はじめに

こんにちは、ネットワーキング事業部 研究開発部の柴田剛志です。

最近、生成AI(人工知能)の技術が急速に進化し、多くの企業や研究機関で活用されています。生成AIは、文章や画像、音声などを生成する能力を持ち、さまざまな業界での応用が期待されています。そのため、この技術を支えるインフラの構築は非常に重要です。

本記事では、生成AIインフラを作るために必要な要素や技術について、わかりやすく説明します。

1.生成AIインフラとは

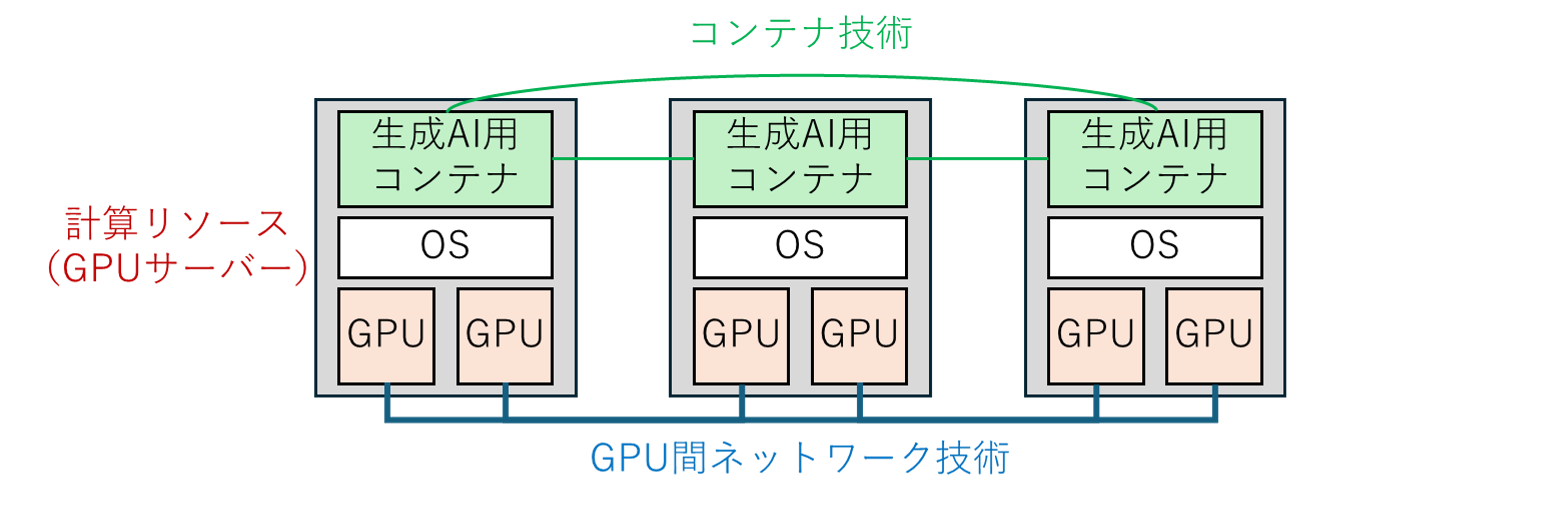

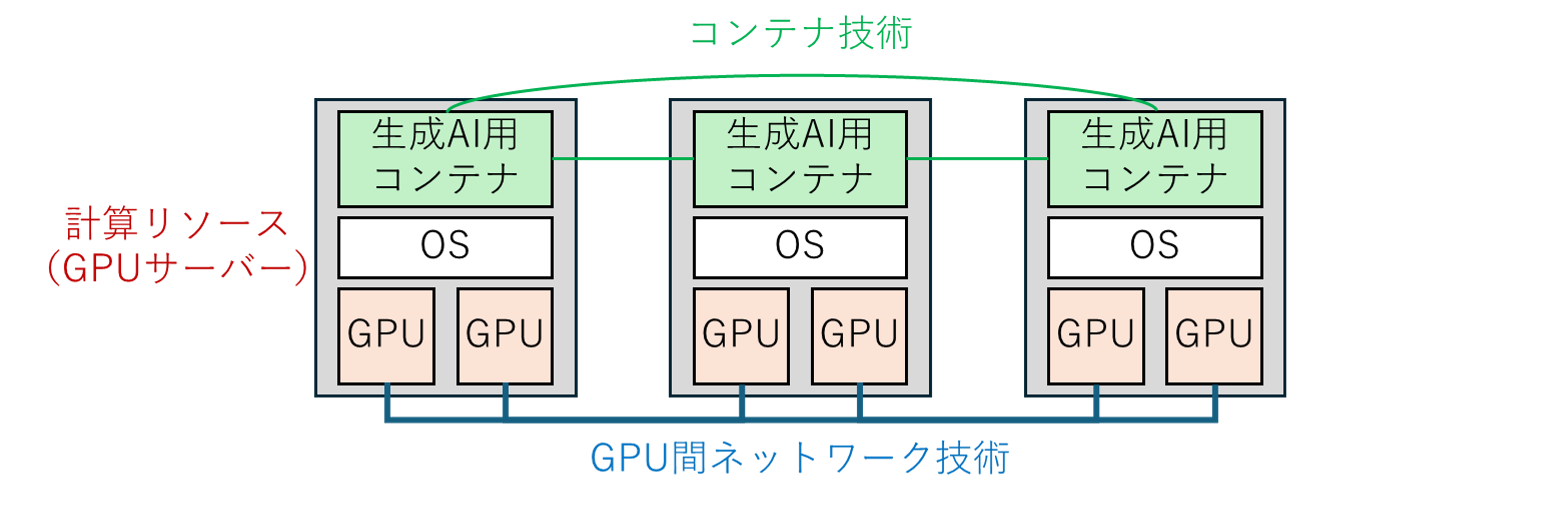

生成AIインフラとは、生成AIモデルを効率的に運用するために必要なハードウェアやソフトウェアの基盤のことです。特に以下の要素が重要です。

・コンテナ技術:利用者ごとのライブラリを簡単に管理できる技術

・計算リソース:大量のデータを処理するためのGPU(Graphics Processing Unit)サーバー

・ネットワーク技術:高速なデータ転送を実現するための通信技術

生成AIインフラの構成図

2.コンテナ技術の重要性

生成AIインフラでは、利用者ごとに異なるライブラリを使用することが一般的です。また、生成AI分野は技術の進歩が速く、必要なライブラリが頻繁に変わるため、コンテナ技術が有用です。

環境の分離

コンテナは、アプリケーションとそのアプリケーションが必要とするライブラリなどの依存関係をまとめたもので、独立した環境を提供します。これにより、以下の利点があります。

・ファイルシステムの分離:各コンテナは独自のファイルシステムを持ち、他のコンテナと隔離されているため、ライブラリの競合を防ぎます

・プロセスの分離:各コンテナは独立したプロセス空間で動作し、他のコンテナのプロセスに影響を与えません

簡単なデプロイ

コンテナを使用することで、アプリケーションのデプロイが簡単になります。従来の方法では、依存関係を手動でインストールする必要がありましたが、コンテナを使うことでその手間が省けます。

3.計算リソースの管理とシステム運用

生成AIインフラにおいて、計算リソースの効率的な管理は非常に重要です。Kubernetes*1は、コンテナを効率的に管理・オーケストレーションする強力なツールであり、計算リソースを最適化して生成AIモデルのトレーニングや推論を支える役割を果たします。以下の3つのポイントに焦点を当てて、Kubernetesが生成AIのためにどのように最適化されるべきかを考察します。

3.1 スケーラビリティと効率的なリソース管理

生成AIモデルは、トレーニングや推論の際に大量の計算リソースを必要とします。

Kubernetesは、トラフィックや負荷に応じてコンテナの数を自動的に調整する機能を提供します。これにより、リソースを最適に利用し、コストを削減しつつ、必要なパフォーマンスを維持できます。また、Kubernetesは特定のコンテナに対してGPUを割り当てることができるため、GPUリソースの効率的な管理が可能です。

3.2 フレームワークのサポートとデプロイの柔軟性

生成AIは、Hugging Face Transformers*2やLangChain*3など、さまざまなフレームワークを用いて実装されることが一般的です。

Kubernetesは、異なるフレームワークを同時に運用する環境を提供し、各フレームワークの特性を生かしたアプリケーションのデプロイを可能にします。この柔軟性により、開発者は特定のニーズに応じた最適なフレームワークを選択し、効率的に開発を進めることができます。

3.3 可用性と障害復旧

Kubernetesは、障害発生時に自動的に新しいコンテナを立ち上げる機能を持っています。これにより、生成AIアプリケーションの高可用性が確保され、ビジネスの継続性が向上します。特に、リアルタイムでの推論が求められるシステムにおいては、この機能が非常に重要です。Kubernetesの自動復旧機能によって、システムの信頼性が高まり、運用コストの削減にも寄与します。

4.処理遅延を削減するための通信技術

生成AIの処理では、大量のデータがGPU間でやり取りされます。この通信の速度や遅延は、処理時間に大きく影響します。ここでは、処理遅延を大幅に削減する技術としてのRDMA(Remote Direct Memory Access)について説明し、そのRDMAを活用する通信技術であるInfiniBandとRoCE(RDMA over Converged Ethernet)を紹介します。

4.1 RDMA技術の概要

RDMAは、メモリーに直接アクセスできる通信技術で、CPUを介さずにデータを転送することができます。これにより、以下の利点があります。

・低遅延:データ転送時にCPUの介入を最小限に抑えるため、通信の遅延が大幅に削減されます

・高スループット:大量のデータを迅速に転送できるため、特に大規模な生成AIモデルのトレーニングや推論において効果を発揮します

・リソースの効率化:CPUの負荷を軽減し、他の処理にリソースを集中させることが可能になります

これらの特性により、RDMAは生成AIの処理において非常に重要な技術となります。

4.2 InfiniBandとRoCEの活用

InfiniBandとRoCEは、RDMAを活用するための主要な通信技術です。

・InfiniBand:高速データ転送を実現する専用ネットワーク技術で、RDMAを利用することで高帯域幅と低レイテンシを提供します。これにより、生成AIモデルのトレーニング時間を短縮し、リアルタイムでのデータ処理が可能になります。

・RoCE:イーサネット上でRDMAを利用する技術で、コスト効率が高く、既存のイーサネットインフラに統合可能です。これにより、低遅延でのデータ転送が実現し、生成AIの性能を向上させます。

これらの技術を組み合わせることで、生成AIの処理効率を大幅に改善することができます。

5.まとめと今後の展望

生成AIのインフラ構築は、技術的な挑戦が多い一方で、非常に興味深い分野です。GPUサーバーやコンテナ技術、ネットワーク技術を駆使することで、効率的で強力な生成AI環境を実現できます。今後、生成AIの活用範囲はさらに広がると考えられています。興味がある方は、ぜひこの分野に挑戦してみてください。

また、この記事についての感想や質問があれば、お問い合わせフォームなどでぜひお知らせください。また、SNSでのシェアも大歓迎です。

2025年4月

株式会社 日立情報通信エンジニアリング

ネットワーキング事業部 ネットワーキング事業企画本部 研究開発部 柴田 剛志

※編集・執筆当時の記事のため、現在の情報と異なる場合があります。編集・執筆の時期については、記事末尾をご覧ください。