はじめに

こんにちは、ネットワーキング事業部DCエンジニアリング本部第1部の鈴木友之です。

生成AIと言えば、ChatGPTを思い浮かべる人が多いと思います。ChatGPTは2022年末に公開されて以来、幅広い分野の質問に詳細な回答を生成できることから、誰もが利用できる便利なツールとして大きな注目を集めてきました。

そんな生成AIですが、スマートフォンからでも気軽に利用できる使い勝手や的を射た回答に関心が集まる一方で、どのようなハードウェア基盤で動いているのかについては、あまり語られていないのが実情です。私が携わっているAIインフラソリューション分野においても、さまざまなメーカーの機器を組み合わせて一つのシステムを創り上げており、ハードウェア基盤の重要性が再認識されています。

なぜハードウェア基盤に注目?

そもそも、なぜハードウェア基盤に注目するのかと言うと、生成AIを業務で効果的に活用するためには、どうしても独自の環境が必要になるからです。一般的な情報収集やちょっとした疑問であれば、ChatGPTに聞いてみるのも良いでしょう。

しかし、社外秘の情報やまだ公開されていない製品開発の内容を扱いたければ、独自環境を用意しなければなりません。そうしないと、社内の重要な情報やせっかく練り上げたアイデアが外部に漏れてしまうリスクが高まりますよね。

そのため、企業が大規模な製品開発や高度なサービスに生成AIを活用しようとすると、強力なハードウェア基盤を備えた独自環境の導入が重要な選択肢の一つとなります。

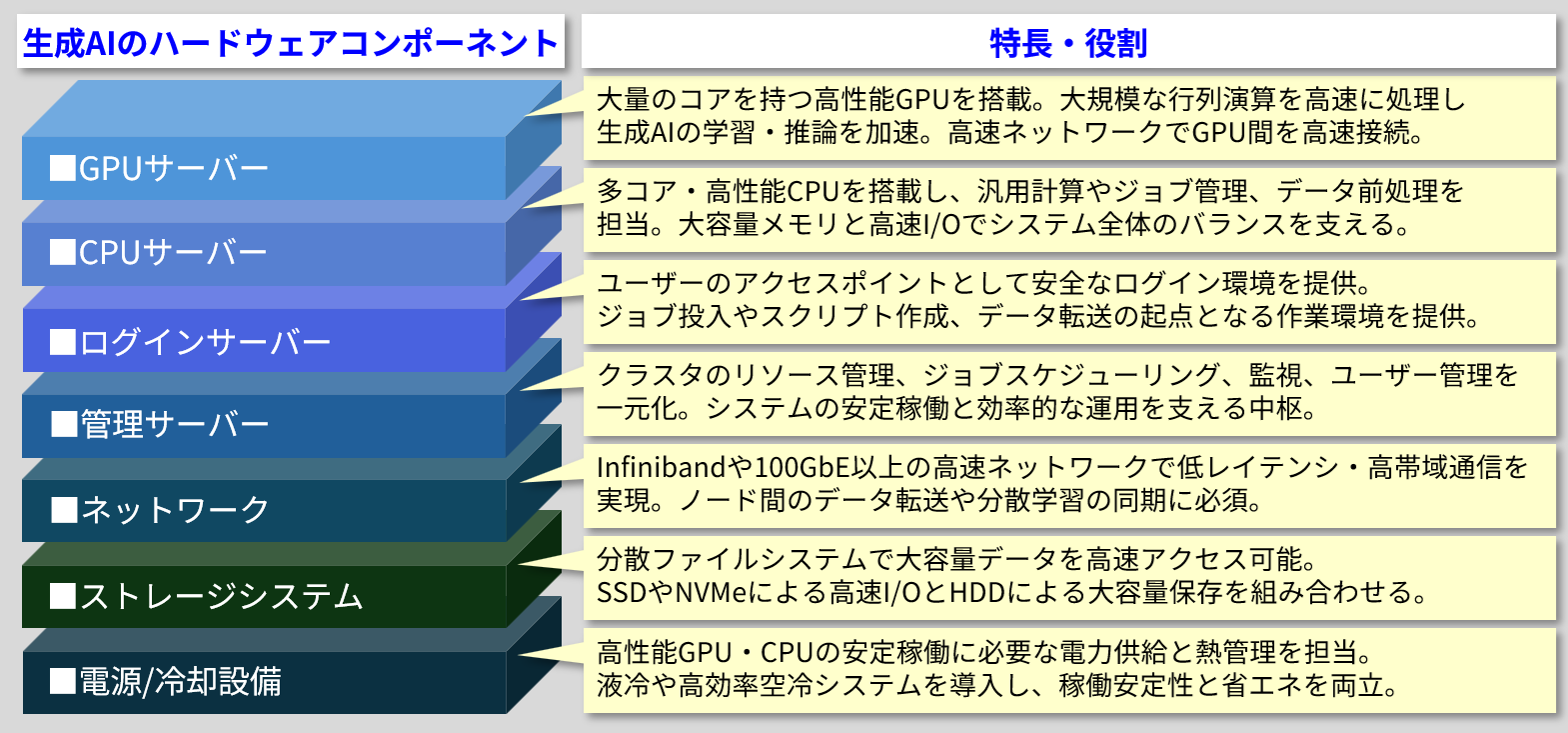

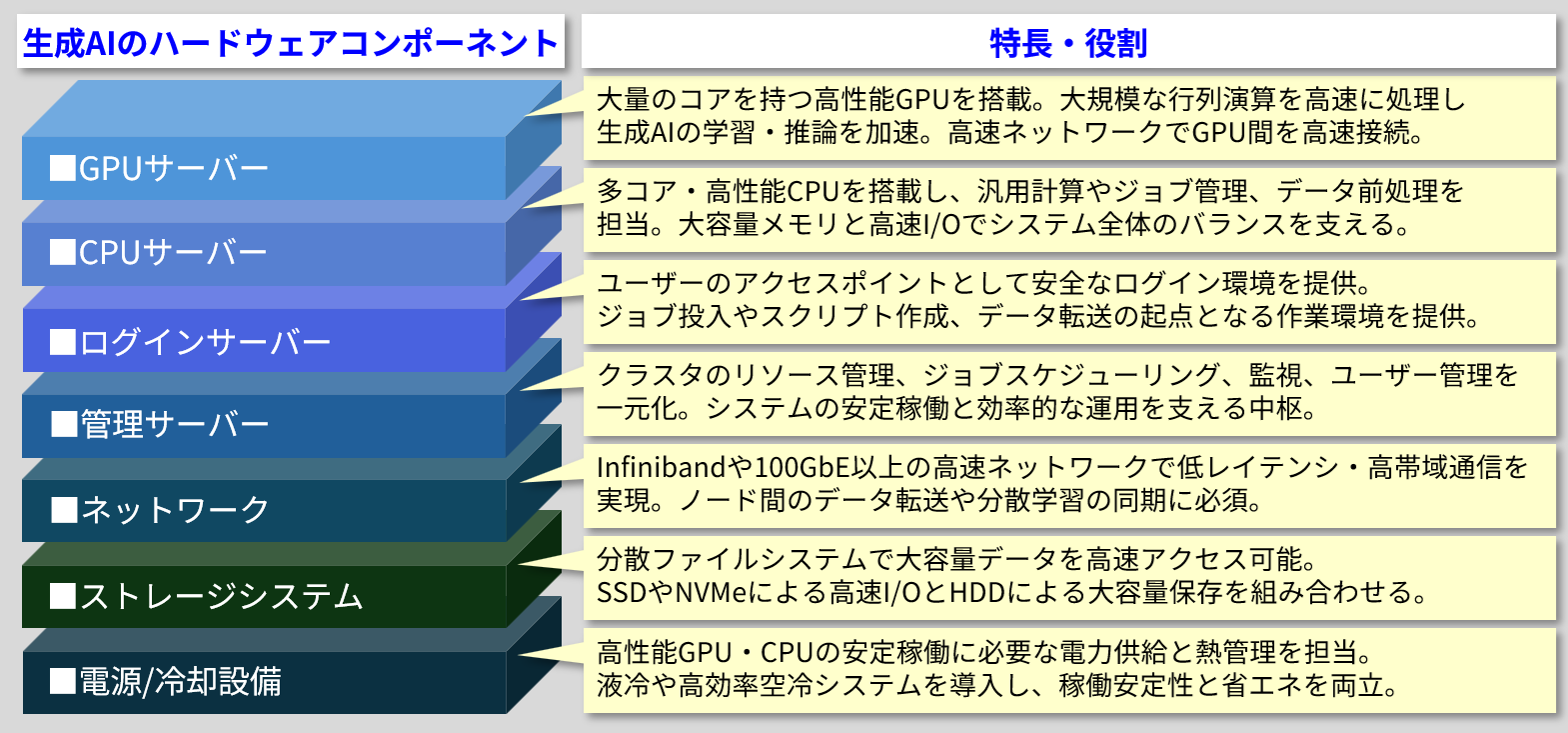

では、具体的にどのような機器が使われているのでしょうか?

生成AIに必要なハードウェア

GPU/CPUサーバー

生成AIが大量のデータを処理し、高度な推論を行うためには、膨大な計算が必要です。

GPU(Graphics Processing Unit)は、大量のデータを同時に並列処理する能力に優れており、複雑なAIアルゴリズムを高速に処理することが可能です。このGPUを複数搭載したサーバーをさらに数十台から数百台並列で稼働させることで、処理速度を飛躍的に向上させ、高性能なデータ処理を実現しています。

また、CPU(Central Processing Unit)サーバーは、GPUがあまり得意ではないユーザーからのリクエストやデータの整理など、システム全体の制御や多様な処理を担うことで、生成AIのパフォーマンスを最大限に引き出すことが可能になります。

ログイン/管理サーバー

ログインサーバーは、利用者がシステムにログインするための入り口を担っています。SSH(Secure Shell)などのプロトコルによるリモート接続手段を提供し、認証・アクセス制御を行うことで、不正アクセスを防止しています。

また、ログの取得・監査が可能で、利用状況の追跡なども行っています。

管理サーバーは、生成AIを動かすための各種サーバーやリソースを統括・監視する司令塔のような役割を担っています。GPUサーバーやCPUサーバー、ログインサーバーなど、多数のサーバーが連携して動作する中で、全体の状況を把握し、負荷の偏りを防いでシステム全体のリソース効率を最大化します。

ネットワーク/ストレージシステム

生成AIは大量のデータを扱うため、ネットワークは高速かつ安定したデータ伝送が求められます。

特にGPUサーバーやストレージシステム間の通信では、膨大な計算結果や学習データを迅速にやり取りする必要があります。高速なネットワークがあることで、生成AIの処理速度や応答品質が大きく向上します。

また、生成 AI におけるストレージシステムは、NVMe(Non-Volatile Memory Express)プロトコル対応のSSD(Solid State Drive)など高速ストレージを採用することで、膨大なデータを効率的に保存し、迅速にアクセスできるようにする役割を担っています。

さらに、分散ファイルシステムを活用してデータを複数のストレージノードに分散させることで、並列処理を可能にし、高いスループットと低レイテンシを実現。モデルのトレーニングや推論を加速します。

電源/冷却設備

生成AIの処理は非常に高負荷で、GPUやCPU、ストレージは大量の電力を消費します。

電源はこれらのコンポーネントに対して、安定かつ十分な電力を供給する役割を担っています。

24時間365日稼働する生成AIシステムでは、複数の電源ユニットを並列運用し、故障時もシステムが停止しないよう設計されています。

また、消費電力が大きいということは、非常に高い熱が発生することを意味しています。

一般的なアプリケーションサーバーであれば装置内蔵の空冷ファンで事足りますが、高性能GPUサーバーとなると、空冷だけでは冷却が困難になるため、液冷モデルが採用されます。

こうなると機器を導入するデータセンター側にも液冷に対応した設備(冷却水の循環設備など)が必要になってくるため、大規模システムを構築するには膨大な設備投資も必要になります。

まとめ

いかがでしたか?

これらのハードウェアコンポーネントは、PoC(Proof of Concept)や推論環境といった単一プロジェクトでのAI開発から、大規模な学習環境によるAIモデル開発に至るまで、用途や規模に応じて最適な機器を選定することで、期待される処理能力に見合った高いコストパフォーマンスを実現します。AIインフラソリューションにおいても、お客さまのニーズに最適なハードウェアリソースを提案・提供することで、生成AI市場の成長を牽引しています。

生成AIは、大量のデータをもとに新しいテキストや画像、音声を作り出す高度な機械学習モデルです。これらのモデルは膨大な計算を必要とするため、専用のハードウェアが不可欠です。

生成AIの進化はハードウェア基盤の進化なしには語れません。

これからも最新技術の動向に注目していきましょう!

2025年12月

株式会社 日立情報通信エンジニアリング

ネットワーキング事業部 DCエンジニアリング本部 第1部 鈴木 友之

※編集・執筆当時の記事のため、現在の情報と異なる場合があります。編集・執筆の時期については、記事末尾をご覧ください。